인간-인공지능 관계의 패러다임을 바꿀 GPT-4o의 등장 - 멀티모달, 감정 표현, 실시간 소통의 혁신

안녕하세요! 오늘은 최근에 공개된 GPT-4o에 대해 살펴보고, 이를 통해 인공지능과 사람의 소통 방식이 어떻게 변화할지에 대해 이야기해보려고 합니다.

인간보다 풍부한 감정을 보여주는 GPT-4o

생일축하 노래를 불러주는 GPT-4o

먼저 이 영상을 보시면 챗GPT의 혁신적인 모습을 확인할 수 있습니다.

영상에서 인공지능은 연속된 이미지와 음성 정보(영상)를 토대로 상황을 정확히 파악하고 있습니다. 누군가의 생일이라는 것을 알아챈 것이죠. 뿐만 아니라 사람과 거의 비슷한 속도로 답변을 하고 있습니다.

또한 챗GPT는 감정까지 표현합니다. '케이크'나 '생일'이라는 말을 하며 은근히 기대감을 내비치는 것 같았어요. 심지어 생일 축하 노래를 불러달라고 하자 머쓱한 듯이 노래까지 불러주더라고요.

영상에선 오히려 인공지능의 감정이 사람보다 더 풍부해 보이기까지 했습니다.

인공지능과 소통하는 방식의 변화 / 패러다임의 전환

앞서 살펴본 영상은 챗GPT를 통해 인간과 인공지능의 상호작용 방식이 크게 달라질 것임을 예고하고 있습니다.

과거에는 사람이 텍스트나 음성으로 정보를 제공하면, 인공지능이 이를 처리하고 다시 텍스트로 변환해 전달하는 방식이었죠.

이 과정에서 반응 속도가 느려질 수밖에 없었고, 감정이 결여되어 기계와 대화한다는 느낌을 주곤 했습니다. (기존 음성모드에선 답변을 얻기까지 평균 2.8초(GPT-3.5) 혹은 평균 5.4초(GPT-4)가 소요)

하지만 이제는 이러한 패러다임 자체가 바뀌게 되었습니다.

바로 어제(5월 13일, 현지시각) 공개된 GPT-4o 모델이 이 혁신의 중심에 서 있습니다.

주목할 만한 GPT-4o의 기능과 활용 사례 모음

믿기 어려울 정도로 뛰어난 GPT-4o의 능력, 궁금하지 않으신가요?

지금부터 여러분의 상상력을 자극할 GPT-4o의 핵심 기능과 흥미진진한 활용 사례들을 소개합니다!

최초의 멀티모달(Multimodal) GPT 모델

텍스트, 오디오, 이미지 등 다양한 형식의 정보를 사람처럼 빠르고 정확하게 이해하는 것(멀티모달, Multimodal)이 GPT-4o의 가장 큰 특징입니다. 320밀리초 만에 오디오 입력에 응답할 수 있을 정도로 처리 속도가 빨라졌고, 이는 사람과 거의 유사한 수준이라고 합니다.

- 과거: 사람의 입력(텍스트, 음성) → 인공지능 처리 → 텍스트 변환 및 전달 (느린 반응 속도, 감정 결여)

- 현재: GPT-4o의 등장으로 종합적인 정보를 실시간으로 처리

감정 이해 및 표현 능력의 향상

GPT-4o는 인간의 감정을 이해하고 표현하는 능력이 크게 향상되었습니다.

- 자장가 부를 것을 요청하자 부끄러워하지만 결국 불러줌

- 자장가를 부르던 중 사람의 지시에 따라 창법을 변경하는 모습을 보여줌

사용자의 요구에 맞춰 다양한 버전의 자장가를 불러주는 GPT-4o

실시간 쌍방향 소통의 구현

GPT-4o는 사람과의 실시간 쌍방향 소통을 가능하게 합니다.

- 위 영상에서 GPT-4o의 빠른 응답 속도를 확인할 수 있음

- GPT-4o가 말하는 도중 사람이 끼어들어도 즉시 정보를 파악하고 답변할 수 있음

- 이전 모델에서는 GPT가 처리와 대답을 하는 동안 사용자의 추가 입력을 받을 수 없었음

- GPT-4o에서는 실시간 정보 교환이 가능해져 더욱 자연스러운 쌍방향 소통을 구현함

수학 문제풀이 과외

개인적으로 가장 충격을 받았던 장면입니다. GPT-4o는 이제 학생들의 수학 문제풀이를 도와주는 과외 선생님 역할을 수행할 수 있습니다.

- 영상에서는 학생이 문제를 풀 때 GPT-4o가 실시간으로 도움을 주는 모습을 볼 수 있음

- GPT-4o는 간단한 기하 문제를 친절하게 설명하고 가르칠 수 있음

- 아직 복잡한 고난도 문제는 어려울 수 있으나, 초등학교와 중학교 수준의 문제풀이는 충분히 가능할 것으로 예상됨

실시간으로 수학 과외를 해주는 GPT-4o

아주 우수한 실시간 통역

GPT-4o는 아주 우수한 실시간 통역 서비스를 제공할 수 있습니다.

- 직역이 아닌 의역을 통해 발화자의 의도를 정확히 전달

- 중간에 말을 끊어도 즉시 반영하여 통역 가능

- 매우 빠른 처리 속도로 실시간 통역 구현

실시간 통역을 하는 GPT-4o

개인화된, 감정을 담은 고객 응대(Customer Service)

GPT-4o를 활용하여 기존 ARS 서비스보다 훨씬 향상된 음성 안내 서비스를 제공할 수 있습니다.

- 고객의 상황에 맞춤화된 대화형 응대 가능

- 감정을 담아 고객을 응대함으로써 감정노동 대체 효과

고객 응대 서비스를 진행하는 GPT-4o

여행 가이드, 상황 해설

GPT-4o는 실시간으로 영상과 사진 정보를 분석하여 여행 가이드 역할을 수행할 수 있습니다.

- 주변 환경에 대한 실시간 묘사 및 해설 제공

- 시각 장애인도 GPT-4o를 통해 여행 중 주위 환경에 대한 설명을 들을 수 있음

- 택시 도착 시점 포착 및 행동 안내, 동반 반려견 탑승 여부 언급 등 상황 판단 능력 보유

시각 장애인에게 여행 가이드, 상황 해설을 하는 GPT-4o

이외 GPT-4o 모델 주목할 만한 기능들

OpenAI 공식 문서에서 공개한 GPT-4o의 주목할 만한 기능들을 정리해보았습니다.

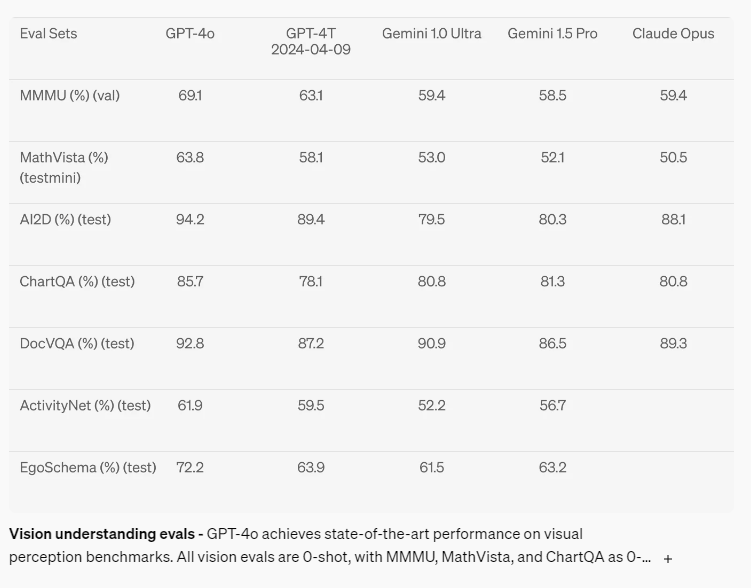

GPT-4o의 이미지 처리 능력

GPT-4o는 현존하는 대규모 언어 모델 중 가장 우수한 이미지 처리 능력을 보유하고 있습니다.

- 복잡한 이미지 속 객체, 장면, 텍스트 등을 정확하게 인식 및 분석 가능

- 이미지에 대한 심층적인 이해를 바탕으로 관련 질의에 대한 답변 제공

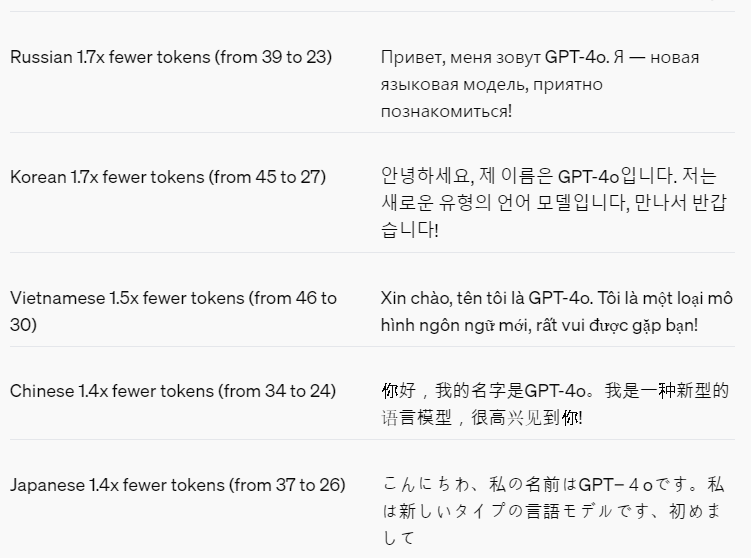

다국어 처리 성능 향상

GPT-4o는 이전 모델 대비 다국어 표현 능력이 크게 개선되었습니다.

- 20개 언어를 다룰 때 토큰 활용이 최적화되어 더 효율적인 처리 가능

(한글은 1.7배 토큰을 절약) - 각 언어의 문법, 어휘, 문화적 맥락을 고려한 자연스러운 번역 및 생성 결과 제공

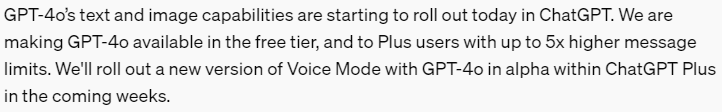

ChatGPT에 GPT-4o 기능 통합 및 음성 모드 알파 버전 출시 예정

향후 몇 주 내에 GPT-4o 기반의 음성 모드 알파 버전도 선보일 예정입니다.

- 무료 및 플러스 사용자 모두 GPT-4o 텍스트, 이미지 기능 이용 가능

- 플러스 사용자는 최대 5배 메시지 한도 증가 혜택 제공

- GPT-4o 음성 모드를 통해 사용자와 ChatGPT 간 자연스러운 음성 대화 가능

GPT-4o API의 경쟁력

GPT-4o API는 기존 GPT-4 터보 모델 대비 월등한 성능과 가격 경쟁력을 자랑합니다.

- 처리 속도가 2배 빨라져 실시간 서비스 구현에 유리

- API 사용 비용은 절반 수준으로 대폭 절감

- 속도 제한이 5배 높아져 더 많은 요청을 안정적으로 처리 가능

GPT-4o가 열어갈 인공지능 소통의 신세계

앞서 소개해드린 GPT-4o의 혁신적인 사례들을 보면서, 여러분도 인간과 AI의 소통에 엄청난 변화가 일어나고 있음을 느끼셨나요?

GPT-4o의 멀티모달 처리, 인간 같은 감정 표현, 실시간 쌍방향 소통 등은 기존의 상식을 깨는 혁신 그 자체라고 할 수 있습니다.

GPT-4o는 아직 초보 단계이지만, 앞으로 계속해서 발전할 것입니다.

우리 일상 곳곳에서 GPT-4o의 놀라운 능력을 마주하게 될 날이 머지않았습니다.

여러분도 GPT-4o와 함께 더 편리하고 효과적인 소통을 경험하실 준비 되셨나요?

마치며

AI Ground는 실무에서 생성형 AI를 활용하는 방안을 교육하고 있습니다.

GPT-4o 모델이 나온 만큼, 연구해서 실무에 적용할 수 있도록 도움을 드리고자 합니다!

GPT-4o 활용 팁, 실무 활용 방안 등은 정리되는 대로 뉴스레터로 발행할 예정이오니 많은 관심 부탁드립니다!!!

AI Ground 교육이 제공하는 차별화된 학습 경험

AI Ground 교육 프로그램은 기업 실무에서 생성형 AI 기술을 효과적으로 활용할 수 있는 역량을 기르는 것을 목표로 하고 있습니다. 이론 교육과 함께 실습 위주의 체험식 학습을 강조하는 것이 교육 철학입니다.

- 다양한 생성형 AI 도구를 직접 활용해볼 수 있는 실습 기회 제공

- 기업에서 실제로 마주칠 수 있는 문제 상황을 가정한 프로젝트 수행

- 유료 ChatGPT 계정 대여를 통한 데이터 처리/분석/시각화, 웹 검색, 파일 학습 등 고급 기능 활용 실습

AI 실무 적용, 어렵지 않아요!

생생한 사례와 전문가의 노하우가 가득한

AI Ground 뉴스레터에서 디지털 전환의 시대를 미리 준비하세요.

지금 바로 구독하고 AI 활용의 노하우를 만나보세요!