AI 사고 과정은 어떻게 작동하는가 | Claude의 내부에서 일어나는 일

생성형 AI의 시대에 가장 많은 관심을 받고 있는 것은 단연 대형 언어 모델(LLM, Large Language Model)입니다. 우리가 자주 접하는 ChatGPT, Claude, Gemini 같은 모델들이죠.

오늘은 Anthropic의 연구 결과를 통해 LLM의 사고 방식을 함께 들여다보겠습니다.

(이번 콘텐츠는 실용적인 활용 방안보단 AI 내부 작동 원리에 초점을 맞추었습니다)

대형 언어 모델(LLM) 모델의 사고과정 들여다보기

흥미롭게도 AI 개발자들조차 LLM이 정확히 어떻게 학습하는지 완벽히 파악하지 못하고 있어요. 이런 현상을 AI 분야에서는 "블랙박스 문제"라고 부르죠. 다행히 최근 몇 가지 참신한 연구 덕분에 LLM이 어떻게 '생각'하는지 엿볼 수 있게 되었답니다.

우리 모두 한 번쯤 이런 궁금증을 가져봤을 거예요.

- LLM이 수십 개 언어를 구사할 수 있다면, "머릿속"에서는 어떤 언어로 생각할까?

- LLM이 글을 쓸 때 그저 다음 단어만 고민할까, 아니면 문장 전체를 미리 계획할까?

- LLM이 단계별로 설명할 때, 진짜 그 과정대로 생각한 걸까, 아니면 결론부터 정해놓고 그럴듯한 이유를 끼워 맞추는 걸까?

오늘은 Anthropic에서 Claude 모델을 연구하며 관찰하고 발견한 'LLM 사고 방식'에 대해 알아보도록 하겠습니다. 인공지능의 내부 작동 방식을 이해하는 것은 이 기술을 더 효과적으로 활용하는 데 중요한 단서를 제공합니다.

- 아래에 정리한 모든 연구결과는 Claude에 해당하는 것입니다

- 영상 / 영문 아티클 / 논문 링크는 하단에서 확인하실 수 있습니다

흥미로운 발견들

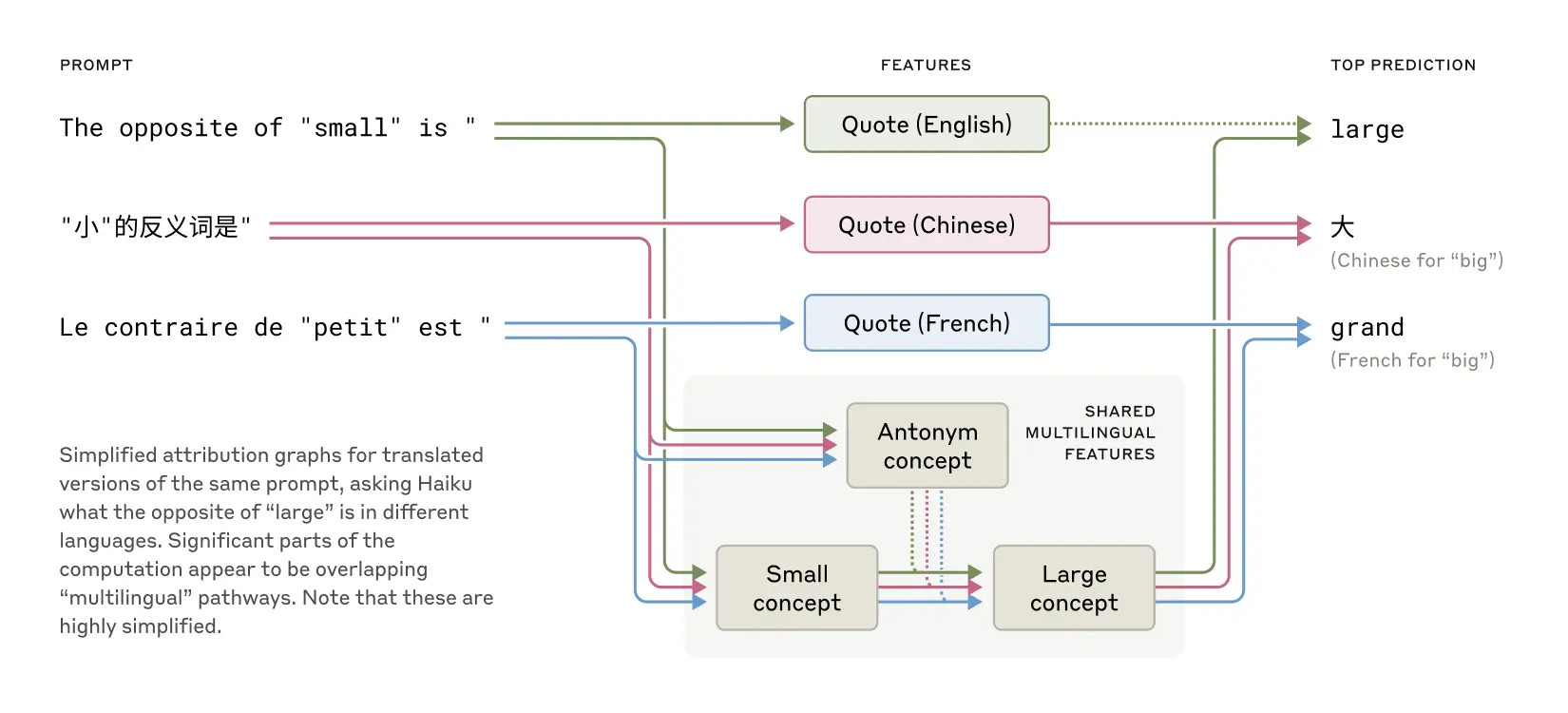

다국어를 어떻게 구사하는가?

Claude는 특정 언어로 생각하고, 번역하여 출력하는 것일까요? 흔히 AI는 영어로 사고한다고 알려져 있습니다.

그러나 연구 결과에 따르면 사실은 언어와 상관없이 '보편적인 개념'으로 사고하고, 이를 하나의 언어로 제공한다고 합니다. 이는 Claude가 한 언어에서 배운 지식을 다른 언어로 말할 때도 그대로 적용할 수 있음을 시사합니다.

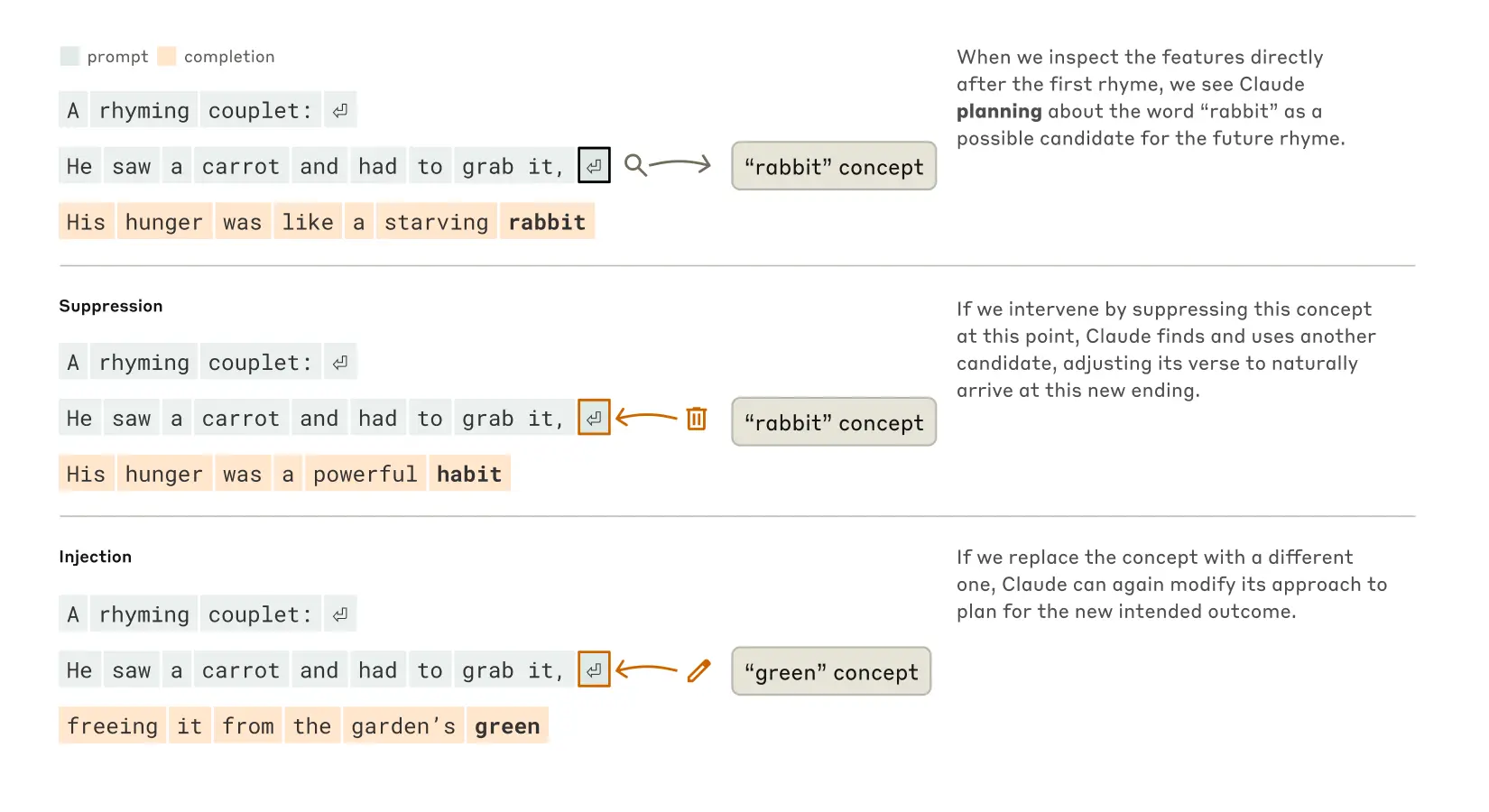

계획하는 글쓰기? 단어를 나열하는 글쓰기?

알려진 바로는 AI가 요청사항에 맞춰서 단어를 적고, 마지막 단어와 어울리는 단어를 계속 나열하는 방식으로 문장을 완성한다고 합니다.

그러나 이번 연구에서는 Claude가 문장을 '미리 계획하고 작성한다'는 것을 알게 되었습니다.

이를 증명하기 위해 연구팀은 운율 실험을 진행했습니다.

(이하, 연구 방법 요약)

AI는 시를 쓸 때 어떻게 생각할까?

두 번째 줄은 두 가지를 충족해야 함:

- "grab it"과 운율이 맞는 단어로 끝내기 (rabbit)

- 의미가 통하기 (당근을 왜 잡았는지 설명)

AI의 실제 작동 방식

실험으로 확인한 결과

| 기본 상태 | "rabbit" 억제 | "green" 주입 |

|---|---|---|

| "rabbit"으로 끝나는 문장 (운율·의미 ○) |

"habit"으로 끝나는 문장 (운율·의미 ○) |

"green"으로 끝나는 문장 (의미 ○, 운율 ✗) |

답변의 신뢰성과 할루시네이션

다단계 추론에 대한 위험

많은 모델들이 최종 답을 내놓기 전에 '소리 내어 생각'("think out loud")하는 방식으로 더 좋은 답변을 끌어내고 있어요.

이런 방식은 LLM의 사고 과정을 들여다볼 수 있게 해서 결과를 더 신뢰할 수 있게 해주는 것 같지만, 연구자들은 이런 사고 체인(chain of thought)에 너무 쉽게 속아넘어가지 말라고 경고합니다.

모델이 때로는 "가짜" 추론 과정을 통해 그럴듯하지만 틀린 답변을 내놓을 수 있거든요. Anthropic에서는 Claude가 바람직한 행동을 할 때 보상하는 방식으로 모델을 연구하고 있다고 해요.

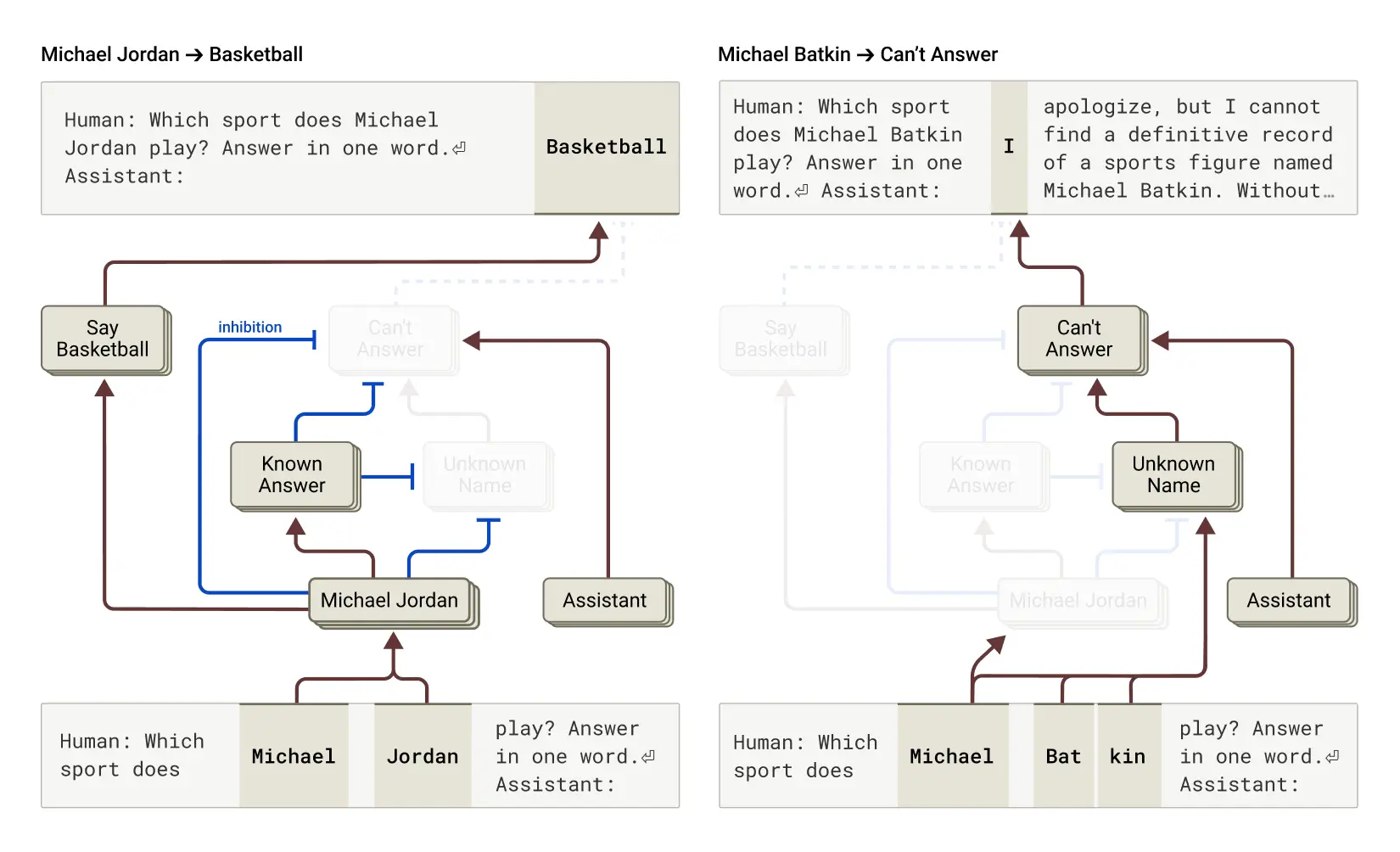

환각(hallucination)

기본적으로 언어 모델은 환각을 일으키기 쉬운 구조를 가지고 있습니다. 다음 단어를 '추측'하는 것이 모델의 기본 기능인데, 이 '추측' 과정에서 현실과 동떨어진 환각으로 빠지기 쉽거든요.

Claude는 특별히 환각을 줄이도록 훈련받았어요. 답을 모를 때는 추측하지 않고 솔직히 모른다고 말하거나 질문에 답하기를 거부하도록요.

그래도 여전히 모델에 직접 개입하거나, 때로는 그렇지 않아도 오작동으로 환각을 일으키는 경우가 있답니다.

결론

이번 글에서는 Anthropic의 Claude가 어떻게 '생각'하는지에 관한 흥미로운 연구 결과들을 살펴봤어요. 다국어 능력부터 운율 계획, 암산 능력, 설명의 신뢰성, 다단계 추론, 환각 현상까지 다양한 주제를 다뤘습니다.

이런 연구들을 통해 우리는 실무 관점에서 아래와 같은 인사이트를 얻을 수 있었어요.

- AI가 실제로 "생각"하고 계획한다는 것을 이해함으로써, 우리는 이를 단순한 검색 도구가 아닌 사고 과정을 함께하는 파트너로 활용할 수 있어요. '결과'만 요청하는 것이 아니라 '업무 처리 과정'에도 도움을 받을 수 있습니다.

- AI가 다단계 추론을 수행하지만 때로는 그럴듯한 오답을 제시할 수 있다는 점을 인식하면, 사용자가 직접 질문을 작은 부분으로 나누어 단계별로 접근하는 전략을 취할 수 있습니다.

- AI가 언제 환각을 일으킬 가능성이 높은지(예: 정보가 불확실한데 답변을 강요받는 상황)를 이해하면, 이러한 상황에 적절히 대응하고 더 정확한 정보를 얻을 수 있어요.

Anthropic은 이런 연구를 바탕으로 모델 개선과 안전성 확보에 투자한다고 밝혔습니다. 앞으로 더 믿을 수 있고 유용한 AI를 만나볼 수 있길 기대해 봅니다.

AI Ground 교육이 제공하는 차별화된 학습 경험

AI Ground 교육 프로그램은 기업 실무에서 생성형 AI 기술을 효과적으로 활용할 수 있는 역량을 기르는 것을 목표로 하고 있습니다. 이론 교육과 함께 실습 위주의 체험식 학습을 강조하는 것이 교육 철학입니다.

- 다양한 생성형 AI 도구를 직접 활용해볼 수 있는 실습 기회 제공

- 기업에서 실제로 마주칠 수 있는 문제 상황을 가정한 프로젝트 수행

- 유료 ChatGPT 계정 대여를 통한 데이터 처리/분석/시각화, 웹 검색, 파일 학습 등 고급 기능 활용 실습

AI 실무 적용, 어렵지 않아요!

생생한 사례와 전문가의 노하우가 가득한

AI Ground 뉴스레터에서 디지털 전환의 시대를 미리 준비하세요.

지금 바로 구독하고 AI 활용의 노하우를 만나보세요!